Künstliche Intelligenz für die Bilderkennung

Deep Learning

Erinnern Sie sich noch an Deep Blue? Das war der Computer von IBM, der 1986, also vor genau 30 Jahren, den Schachweltmeister Garri Kasparow schlug. Was damals wie ein Weltwunder gefeiert wurde, ist heute nur noch eine technische Anekdote aus der Steinzeit der Künstlichen Intelligenz (KI). Deep Blue bezog seine Spielstärke vor allem aus 36 Gigabyte RAM, auf denen er über 100 Millionen mögliche Stellungen pro Sekunde berechnen konnte. Dagegen war Kasparow machtlos. Aber inzwischen braucht selbst ein Spielecomputer 16 bis 32 GB RAM, damit er nicht ruckelt.

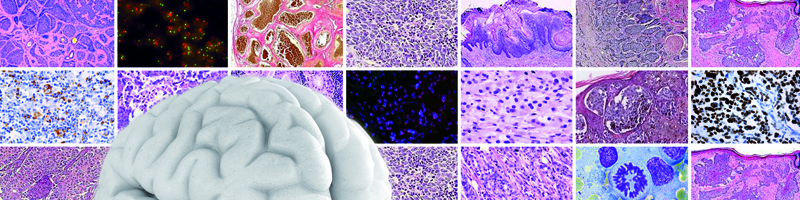

Wenn man heute von KI spricht, dann denkt man nicht mehr an Deep Blue, sondern vielmehr an „Deep Learning“ – also an selbstlernende Algorithmen. Die Basis dafür sind künstliche neuronale Netze, die eigentlich auch schon viele Jahrzehnte auf dem Buckel haben; die zugrundeliegende „Hebbsche Regel“ stammt aus dem Jahr 1959. Solche Netze wurden aber in den letzten zehn Jahren nach dem Vorbild des Gehirns in Richtung Vielschichtigkeit weiterentwickelt und im Zeitalter von Big Data mit ungeheuren Datenmengen trainiert. Mittlerweile gelten sie vor allem bei der automatischen Ton- und Bildanalyse als Technik der Wahl, zum Beispiel im Smartphone und bei der Videoüberwachung – und bald vielleicht auch in der digitalen Pathologie.

Anders als ein Schachcomputer, der letztlich doch nur die Regeln eines von Menschen erfundenen Spiels abarbeitet, kommt es bei der Bildinterpretation darauf an, die „Bedeutung“ einer optischen Wahrnehmung zu erfassen. Das ist ein gewaltiger Unterschied, denn der Lösungsraum eines starren Regelwerks – wie groß er auch immer sein mag – ist endlich, während die Zahl möglicher „Deutungen“ bei einem aus Milliarden von Pixeln bestehenden Bild (also etwa einem gefärbten Gewebeschnitt) unendlich ist. Deshalb mussten die alten, regelbasierten KI-Systeme irgendwann an der Komplexität der Aufgaben scheitern.

Die neuen Ansätze basieren auf einer ganz allgemein gehaltenen Vorschrift, die lediglich besagt, wie beliebige Informationen mit beliebigen Bedeutungen verknüpft werden sollen. Die künstlichen „Neuronen“ darf man sich dabei nicht als etwas physikalisch Greifbares vorstellen; es handelt sich vielmehr schlicht um variable Zahlenwerte, zum Beispiel um die Farbwerte von Pixeln.

Wie ihr natürliches Vorbild lernen diese Neuronennetze aus der Erfahrung, indem sie zwischen den Farbwerten und der Bedeutung eines Bildes Abertausende von Verbindungen – ähnlich den Synapsen des Nervensystems – herstellen. Legt man so einem Programm als einfache Übung zum Beispiel abwechselnd lachende und weinende Smileys vor, so vergibt es im Verlauf des Trainings an die Verbindungen zwischen Mundgegend und Gesichtsausdruck hohe Werte, allen übrigen aber sehr niedrige oder negative Werte.

Diese Basistechnik ist wie gesagt bereits alt und eignet sich nur für relativ einfache Erkennungsaufgaben. Beim Deep Learning legt man nun Hunderte solcher Variablenschichten übereinander und trainiert sie mit Millionen von Bildern. Die unterste Schicht unterscheidet dann beispielsweise nur Flächen von Linien, die nächste rundliche von länglichen Formen, und irgendeine sehr viel höhere Schicht womöglich entartete von normalen Zellen.

Noch ist das Deep Learning in der digitalen Pathologie Gegenstand der Forschung. Aber es gibt bereits sehr erfolgreiche Wettbewerbe, bei denen Informatiker und Pathologen gemeinsam antreten, um beispielsweise den Mitoseindex in Brustkrebspräparaten zu bestimmen (AMIDA13 Challenge, USA) oder Metastasen in Sentinel-Lymphknoten zu erkennen (CAMELYON16 challenge, Niederlande). Mit praktisch nutzbaren Ergebnissen könnte also bereits in wenigen Jahren zu rechnen sein.

Prof. Dr. med. Georg Hoffmann

Mitglied der Redaktion