Alles von Allem erfassen

2013 wurde die Definition von den beiden IT-Publizisten Viktor Mayer-Schönberger und Kenneth Cukier in dem Bestseller Big Data: Die Revolution, die unser Leben verändern wird erneut modifiziert. Während Daten im 20. Jahrhundert – so die Autoren – etwas sehr Wertvolles waren, das man mit wissenschaftlicher Akribie erheben und auswerten musste, könne und solle man heute einfach „Alles von Allem“ erfassen, um gezieltere Aussagen für den Einzelfall machen zu können. So etwa arbeiten beispielsweise NSA oder Amazon: Die einen möchten unter Tausenden von Verdächtigen den Terroristen herausfiltern, der gerade ein Attentat plant, die anderen schlagen jedem, der etwas im Internet bestellt, in Sekundenbruchteilen genau das Produkt vor, das er als nächstes kaufen möchte.

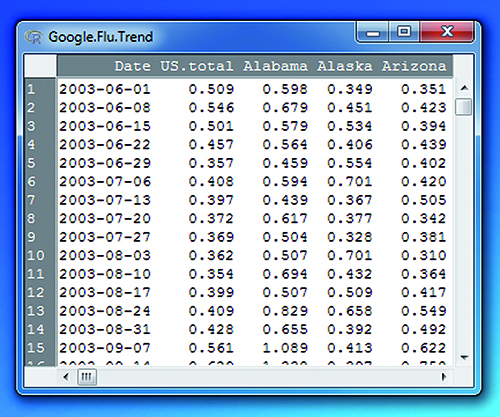

Diese publizierten Definitionen beschreiben recht gut die aktuell erfolgreichen Big-Data-Anwendungen, aber passen sie auch zur Medizin? Die Verfechter der Technologie behaupten: Ja. Als Beispiel führen sie gern das Programm „Google Flu Trends“ (GFT) aus dem Jahr 2008 an, das aufgrund von Suchanfragen nach Grippesymptomen angeblich Ausbrüche von Influenza (engl. flu) ein bis zwei Wochen früher vorhersagen kann als die Gesundheitsbehörden (s. Abb.).

Die Botschaft wurde gern geglaubt, weil sie plausibel klang. Doch als GFT die Grippewelle von 2013 völlig verpasste und auch in den Folgejahren immer wieder versagte, stellte Google den Service wieder ein. Angesichts so unspezifischer Krankheitszeichen wie etwa Husten und Fieber wird kein Diagnostiker, der mit Begriffen wie Sensitivität und Spezifität vertraut ist, über diesen Misserfolg erstaunt sein.

Übertragung auf die Labormedizin

Darf man deshalb die Übertragbarkeit erfolgreicher Big-Data-Algorithmen auf die Medizin grundsätzlich infrage stellen? Oder sollte man lieber geeignetere Vorbilder ausfindig machen als ausgerechnet Anfragen an eine Suchmaschine? Bei der Videoüberwachung auf U-Bahnhöfen liefern zum Beispiel verschiedene Kameras ständig eine Flut von Daten – ähnlich wie die Analysenautomaten im Labor. Algorithmen filtern Umrisse und Strukturen von Menschen und Gegenständen heraus und versuchen, aus Veränderungen Gefahren zu erkennen. Die Analogie zu diagnostischen Fragestellungen wie etwa der Krebsfrüherkennung aus Blutwerten liegt auf der Hand: Auch hier geht es ja um das Erkennen potenziell gefährlicher Konstellationen, wenn sich tumorassoziierte Biomarker innerhalb eines bestimmten Zeitraums verändern.

In der Labormedizin wurden solche Ansätze zwar immer wieder diskutiert, aber nicht konsequent verfolgt – sei es mangels geeigneter Markerprofile oder aus Kostengründen. Nun aber ergreift der ehemalige Google-Manager Jeff Huber die Initiative: Im Februar 2016 wechselte er zu Illumina, dem Marktführer bei der Hochdurchsatzsequenzierung, um einen preisgünstigen Bluttest für die Krebsfrüherkennung zu entwickeln. Das eigens zu diesem Zweck gegründete Unternehmen Grail verfügt über 100 Millionen Dollar Startkapital, unter anderem von Jeff Bezos (Amazon) und Bill Gates (Microsoft). 2019 soll der Test auf den Markt kommen und preislich so günstig werden, dass ihn sich Millionen von Normalbürgern in regelmäßigen Abständen leisten können.

Ein grundsätzlich neuer Ansatz

Das Verfahren basiert auf dem Prinzip der Flüssigbiopsie, also dem Screening von Millionen DNA-Sequenzen im Blut, aus denen ein Algorithmus diejenigen Schnipsel herausfiltern soll, die tumorverdächtige Mutationen tragen. Der Grail-Ansatz unterscheidet sich von traditionellen Liquid-Biopsy-Strategien insofern, als man nicht gezielt nach bekannten Mutationen wie etwa BRAF, cKIT oder ALK fahndet, sondern einfach „Alles in allen Proben“ analysiert. Die gigantische Sucharbeit nach relevanten Mutationen sollen dann Hochleistungscomputer erledigen, so wie sie bei Google relevante Informationen aus Milliarden von Webseiten extrahieren.

Ob das Konzept aufgeht, muss sich erst noch erweisen. Allein die Tatsache, dass man komplette Tumor-DNA-Sequenzenvon Millionen Menschen kennt, ist noch kein Garant dafür, dass daraus ein medizinischer Mehrwert resultiert.

Ganz im Gegenteil zeigen unsere eigenen Untersuchungen in der AG Bioinformatik der DGKL (www.dgkl.de), dass sich bei der Diagnostik die Beschränkung auf einige wenige, dafür aber sorgfältig ausgewählte Biomarker im Sinne höherer Treffsicherheit auszahlt. Ein Zuviel an (meist redundanter) Information vergrößert dagegen vor allem das Rauschen.

Dazu kommt, dass die Labordiagnostik die Kriterien für Big-Data-Anwendungen nicht in allen Punkten erfüllt. So sind ihre Analysenresultate im Vergleich zu dem, was Twitter, NSA et al. auswerten müssen, recht gut strukturiert (Kriterium Variety), und die Daten eines Patienten ändern sich auch nicht im Sekundentakt (Velocity), sondern allenfalls über Stunden.

Diese Einschränkungen sind aber natürlich kein Nachteil, sondern eher eine Arbeitserleichterung. Und was schließlich das Kriterium Volume betrifft, so kann die Labordiagnostik ihre führende Position als datenintensive Disziplin durch den Einsatz von Hochdurchsatzverfahren künftig noch ausbauen. Deshalb ist sie auch das Fach, das am ehesten von Big Data profitieren dürfte.

Sinnvolle Einsatzgebiete sind vor allem da zu suchen, wo es bisher keine guten Lösungen gibt und etwaige Fehler dieser noch jungen Technologie keinen medizinischen Schaden anrichten können. Attraktiv wäre zum Beispiel der automatisierte Hinweis auf seltene Erkrankungen, an die normalerweise niemand denkt. Wenn eine sehr große Datenbank bereits ähnliche Fälle mit kodierter Diagnose enthält, erkennt der Computer diese anhand bestimmter Symptom- und Wertekonstellationen durch eine Ähnlichkeitsanalyse (vergleiche dazu hier). Ein entsprechender Hinweis auf dem Bildschirm kann für den Arzt und mehr noch für den betroffenen Patienten extrem wertvoll sein. Analog können Hinweise für die Anforderung spezieller, wenig bekannter Labortests gegeben werden, wenn eine Verdachtsdiagnose angeklickt wird. Der Unterschied zwischen "Big Data" und "diagnostischem Pfad" bestünde darin, dass diese Hinweise nicht eingepflegt werden müssen, sondern automatisch aus dem Anforderungsverhalten anderer Ärzte abgeleitet würden – fast wie bei Amazon.