Von der Utopie zur Strategie

Big Data in der Labormedizin

„Big Data“ ist ein Hype – auch in der Medizin. Aber die Meinungen, was sich dahinter verbirgt, gehen weit auseinander, und die praktischen Einsatzgebiete sind unklar. Obwohl die Labordiagnostik nicht alle Kriterien für den Einsatz von Big-Data-Techniken erfüllt, kann sie als datenintensive Disziplin am ehesten davon profitieren. Einsatzmöglichkeiten sind zum Beispiel Krebsfrüherkennung oder Hinweise auf seltene Erkrankungen.

Schlüsselwörter: Big Data, Labormedizin, Google Flu Trends, Krebsfrüherkennung, seltene Erkrankungen

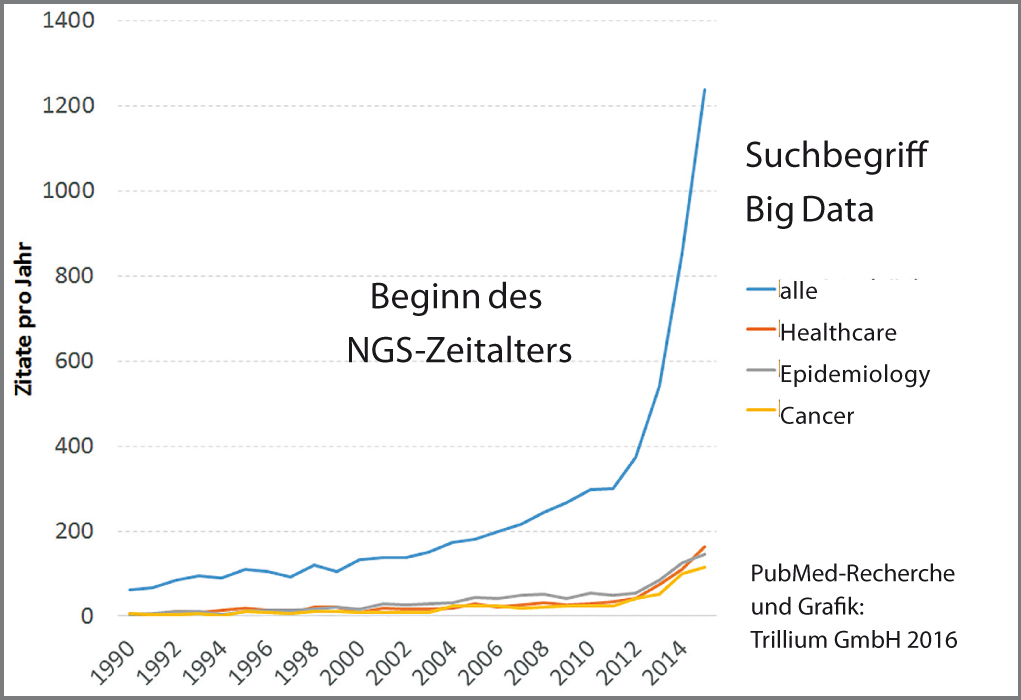

Innerhalb weniger Jahre ist der Begriff Big Data in die Medizin geschwappt – wie eine Flutwelle, auf die niemand richtig vorbereitet war. Einschlägige Diskussionsveranstaltungen und Fachartikel (s. Abb.) schießen wie Pilze aus dem Boden und erwecken gern den Eindruck, man könne über moderne Medizin nur mitreden, wenn man über die Potenziale und Gefahren von Big Data Bescheid weiß. Aber ist das wirklich so? Muss man unbedingt das komplette Krebsgenom eines Patienten sequenzieren, um ihn korrekt behandeln zu können? Ist nicht eher zu befürchten, dass die massenhafte Erhebung und Auswertung von Fitness- und Ernährungsdaten bald alle Gesunden zu Patienten macht? Führt Big Data in der Medizin letztlich zur totalen Überwachung durch die Krankenversicherungen?

Mit diesen und ähnlichen Fragen befasste sich auf Einladung der DAK im März 2016 eine hochkarätig besetzte Expertenrunde. Der Titel der Veranstaltung „Big Data im Gesundheitswesen: Hype oder Hybris“ klang schon fast nach „Skylla oder Charybdis“, und in der Tat blieb die Frage, ob Big-Data-Techniken in der Medizin wirklich Vorteile bringen oder nur Entscheidungen zwischen verschiedenen Übeln zulassen, am Ende offen.

Experten uneins

Prof. Hans Lehrach, Leiter des Berliner Max-Planck-Instituts für molekulare Genetik, berichtete zum Beispiel über Petabyte-schwere Tumorgenom-Datensätze, mit denen er ein Computermodell des Krebses entwickeln will. Es soll nach eigener Aussage „wirklich individualisierte“ (und nicht nur „stratifizierte“) Therapiekonzepte ermöglichen.

Prof. Herbert Rebscher, Vorstandsvorsitzender der DAK-Gesundheit, hielt dagegen: „Solange wir es nicht einmal schaffen, den Unterschied zwischen bakteriellen und viralen Infektionen für die Antibiotika-Verordnung zu nutzen, sollten wir nicht die Hoffnung wecken, jeden Krebs individuell behandeln zu können“. Unter Big Data versteht er eher die statistische Auswertung von Versicherungsdaten, um den Nutzen neuer Therapiekonzepte zu beweisen bzw. zu widerlegen.

Drei Definitionen

Wer hat nun Recht? Die deutsche Übersetzung von Big Data lautet schlicht Massendaten, und in den 1990er-Jahren verstand man auch genau das darunter, nämlich große Datenmengen, die man nicht auf einmal im Computer verarbeiten konnte. Groß ist allerdings relativ, denn damals war ein Terabyte eine erhebliche informationstechnische Herausforderung, während heute allein Google mehrere 100 Petabyte pro Tag einsammelt.

Im Jahr 2001 präsentierte der Wirtschaftsanalyst Douglas Laney dann die sogenannten V3-Kriterien für Big Data, die bis heute als Standard gelten: Neben der schieren Masse (Volume) forderte er, dass die Daten ständig mit hoher Geschwindigkeit in den Computer strömen (Velocity) und weitgehend unstrukturiert sein können (Variety) – so wie das etwa bei den Suchanfragen an Google oder dem „Gezwitscher“ bei Twitter der Fall ist.

Prof. Dr. Georg Hoffmann

georg.hoffmann[at]trillium[dot]de

Prof. Dr. Frank Klawonn

frank.klawonn[at]helmholtz-hzi[dot]de