Leberwerte in neuem Licht

Indirekte Überprüfung von Referenzintervallen

Ab sofort dürfen (und müssen) medizinische Labore die Referenzintervalle in ihrer Labor-EDV anhand von Routinewerten überprüfen. Am Beispiel der Leberwerte wird das praktische Vorgehen erläutert.

Schlüsselwörter: Referenzintervalle, Tukey-Verfahren, QQ-Plot

Das Konzept der Referenzintervalle tauchte bereits vor über einem halben Jahrhundert in der medizinischen Literatur auf [1] und ist seit den 1980er-Jahren als Interpretationshilfe für Laborwerte etabliert [2]. Seine Relevanz für die Zertifizierung und Akkreditierung medizinischer Labore ergibt sich aus der Verankerung in der DIN-Norm 15189 und der Rili-BÄK. Demnach muss jedes Labor seine Referenzintervalle selbst ermitteln und deren Herkunft dokumentieren.

Sofern die Werte aus Herstelleranweisungen oder Lehrbüchern übernommen wurden, genügt es laut CLSI-Dokument C28-A3c, Kapitel 11 [3], die Angaben anhand von jeweils 20 gesunden Kontrollpersonen zu verifizieren. Wenn bei diesem vereinfachten Verfahren nicht mehr als zwei Messwerte außerhalb der Grenzen liegen, gilt die Überprüfung als bestanden.

Dieses Vorgehen ist allerdings wegen der geringen Fallzahl weder repräsentativ für die untersuchte Population noch statistisch robust genug für eine valide Aussage. Zudem bereitet die Rekrutierung von je 20 männlichen und weiblichen Kontrollpersonen – womöglich sogar aus verschiedenen Altersgruppen – erhebliche organisatorische Probleme, die auch durch den Kauf von Proben gesunder Blutspender nicht befriedigend zu lösen sind (Abb. 1).

Direkte und indirekte Verfahren

Werden die Referenzintervalle, wie in der Leitlinie gefordert, unmittelbar aus Messungen an Gesunden abgeleitet, so spricht man von direkten Verfahren. Im Gegensatz dazu sind indirekte Verfahren in der Lage, aus gemischten Kollektiven Gesunder und Kranker den Anteil der statistisch auffälligen Werte abzuschätzen und so „indirekt“ auf das Referenzkollektiv zu schließen [4, 5]. Dadurch wird es prinzipiell möglich, die vorgeschriebene Überprüfung von Herstellerangaben auch ohne Rekrutierung von Kontrollpersonen anhand von Routinewerten aus der Labor-EDV vorzunehmen, wenn dort entsprechende Algorithmen implementiert sind.

Im April 2018 fanden die indirekten Verfahren Eingang in eine offizielle Empfehlung der IFCC [6] – ein Quantensprung, der ganz wesentlich dem Engagement der Arbeitsgruppe Richtwerte der DGKL zu verdanken ist. Prof. Rainer Haeckel, Bremen, und Prof. Thomas Streichert, Köln, beschreiben darin als Koautoren die Vorteile der indirekten Verfahren und fordern verstärkte Forschungsanstrengungen zur praktischen Umsetzung in der Routine [6].

Ein Methodenvergleich

Die im Folgenden beschriebene Pilotstudie ist als Initialzündung gedacht: Sie vergleicht Ergebnisse des direkten und des indirekten Vorgehens am Beispiel von Leberwerten. Hierfür stand ein publizierter Datensatz zur Verfügung [4, 7], der Messwerte von 540 Blutspendern und 75 Hepatitis-C-Patienten mit unterschiedlich ausgeprägter Leberfibrose bzw. -zirrhose enthielt.

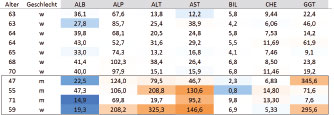

Das bisher empfohlene CLSI-Verfahren wurde auf die gesunden Blutspender angewendet, die neue Empfehlung auf das gemischte Kollektiv von Gesunden und Kranken. Nach Entfernen der Blutspender mit pathologischer Befundkonstellation (Abb. 1) lag die überwiegende Zahl der Messwerte innerhalb der von extern übernommenen Referenzintervalle.

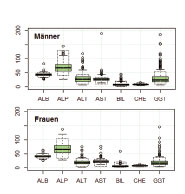

Die grünen Kästen in Abb. 2 repräsentieren jeweils 50% der Messergebnisse (n = 267), die Punkte mögliche Ausreißer. Insbesondere bei den Transaminasen und der GGT fanden sich in den Boxplots deutlich erhöhte Werte als Hinweise auf klinisch stumme Lebererkrankungen. Diese wurden allerdings im Datensatz belassen, um ein realitätsnahes Ergebnis zu erhalten.

Im ersten Teil der Studie berechneten wir die Wahrscheinlichkeit, dass eine kleine Stichprobe (n = 20) mehr als zwei Werte außerhalb des Referenzintervalls liefern würde, wenn alle 20 tatsächlich zur Grundgesamtheit der Gesunden gehören würden. Ohne auf die Mathematik der Binomialverteilung (gesund versus krank) einzugehen, liegt diese bei etwa 7,5%:

1-pbimom(x=2, size=20, prob=0.05)

In dieser Formel besagt die Wahrscheinlichkeit prob=0.05, dass definitionsgemäß 5% der Werte von offensichtlich Gesunden außerhalb des Referenzintervalls liegen.

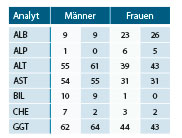

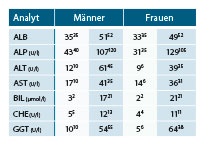

Wendet man die obige Rechenanweisung auf die in Abb. 2 gezeigten realen Verteilungen an, indem man prob=0.05 durch den tatsächlichen Anteil der Werte außerhalb des Referenzintervalls ersetzt, so erhält man die Ergebnisse in Tab. 1 (heller Grund). Daneben stehen die Ergebnisse, die durch Ziehen von je 100 Zufallsstichproben à 20 Blutspendern erhalten wurden.

Die vorhergesagten und tatsächlichen Irrtumswahrscheinlichkeiten stimmen gut überein, sind aber teilweise erschreckend hoch. Je mehr Ausreißer der Datensatz enthält, desto mehr Referenzintervalle werden fälschlich zurückgewiesen; bei den Transaminasen und der GGT kann dies in etwa jedem zweiten Fall geschehen.

Die neue IFCC-Empfehlung

Für den zweiten Teil der Studie mischten wir die Werte der Blutspender mit denjenigen der Hepatitis-C-Patienten, um zu zeigen, dass indirekte Verfahren selbst mit diesen erschwerten Bedingungen gut zurechtkommen. Die neue IFCC-Empfehlung [6] beschreibt mehrere Teilschritte, die sich in drei Stufen untergliedern lassen:

- Datenauswahl und -vorbereitung,

- Entfernung der Ausreißer,

- Berechnung des Referenzintervalls.

Schritt 1 umfasst die Prüfung der Messwertestabilität über den Beobachtungszeitraum, den Umgang mit Mehrfachanforderungen beim selben Patienten („first value“), die Bildung von Subgruppen (Geschlecht, Alter) und den Ausschluss bestimmter Einsender (z. B. Intensivstationen). Diese Schritte kann man meist mit Bordmitteln der Labor-EDV bewältigen

Für die Schritte 2 und 3 gibt es im Internet kostenlose Programme (z. B. Reference Limit Estimator, www.dgkl.de). In der vorliegenden Studie verwendeten wir das Excel-Programm Trillium Normalizer (www.trillium.de/service/software.html). Es entfernt die Ausreißer (Schritt 2) mit einem modifizierten Boxplot-Verfahren (vgl. Abb. 2), das auf einer Normal- bzw. Log-Normalverteilungsannahme basiert. Das Programm wiederholt diesen Schritt so oft, bis es keine Ausreißer mehr findet. Details werden im Einführungskurs "Grundlagen der Referenzintervallüberprüfung" der Trillium Akademie praxisnah erläutert.

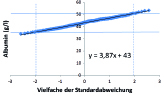

Die Berechnung der Referenzintervalle (Schritt 3) basiert in dieser Studie auf dem QQ-Plot-Verfahren [4]: Dabei werden die aufsteigend sortierten Messwerte grafisch gegen eine standardnormalverteilte Zahlenreihe aufgetragen (Mittelwert 0, Standardabweichung 1). Wenn die Werte normalverteilt sind, ergibt sich eine Gerade (Abb. 3), sind sie lognormal verteilt, so erhält man nach Logarithmierung eine Gerade. Wenn die Kurve trotz Logarithmierung gekrümmt bleibt oder Knicke enthält, sind die Daten ungeeignet; meist überlappen sich dann normale und pathologische Werte zu stark.

Das Referenzintervall liest man entweder grafisch an den Stellen 0±1,96 SD ab (siehe Abb. 3) oder berechnet es aus der Geradengleichung. Auch dieser Schritt wird im obigen Kurs erläutert und anhand von Routinedaten aus der Labor-EDV geübt.

Die mit diesem indirekten Verfahren ermittelten Referenzintervalle stimmen trotz der Beimischung von knapp 15% Hepatitispatienten im Allgemeinen gut mit der Erwartung überein (Tab. 2). In Einzelfällen, etwa bei den Transaminasen für Männer oder der GGT für Frauen, sieht man jedoch deutliche Abweichungen nach oben.

Der Vergleich mit Tab. 1 zeigt, dass bei den Transaminasen und der GGT auch das direkte Verfahren die größten Probleme hatte. Die Abweichungen können also nicht dem statistischen Verfahren zur Last gelegt werden, sondern sind medizinisch begründet: Bei sehr empfindlich reagierenden Leberwerten gelingt die Unterscheidung zwischen gesund und krank nicht einmal für „klinisch unauffällige Blutspender“, und auch die beste Statistik kann dann keine Wunder bewirken.

Fazit

Unser Methodenvergleich zeigt, dass die indirekten Verfahren bei der Überprüfung von Referenzintervallen nicht schlechter abschneiden als die direkten. Da sie aber mit relativ wenig Aufwand aus Routinedaten ermittelt werden können, sollten sie künftig – entsprechend der neuen IFCC-Empfehlung – auch wirklich routinemäßig angewendet werden.